Luego de INTENSO debate que se generó alrededor de las medidas anti pornografía infantil anunciadas por Apple hace unas semanas, la compañía ha anunciado el día de hoy que retrasará su implementación y que estas no llegarán con iOS 15, el cual se espera se anuncie en un par de semanas.

“El mes pasado anunciamos planes para características destinadas a ayudar a proteger a los niños de los depredadores que utilizan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación del material de abuso sexual infantil. Basándonos en los comentarios de clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos un tiempo adicional en los próximos meses para recopilar información y hacer mejoras antes de lanzar estas características de seguridad infantil de importancia crítica”. – Apple

El tema ha dado de qué hablar no por su finalidad, con la que todo el mundo parece estar de acuerdo, sino por la forma en que se ha planteado sea implementada.

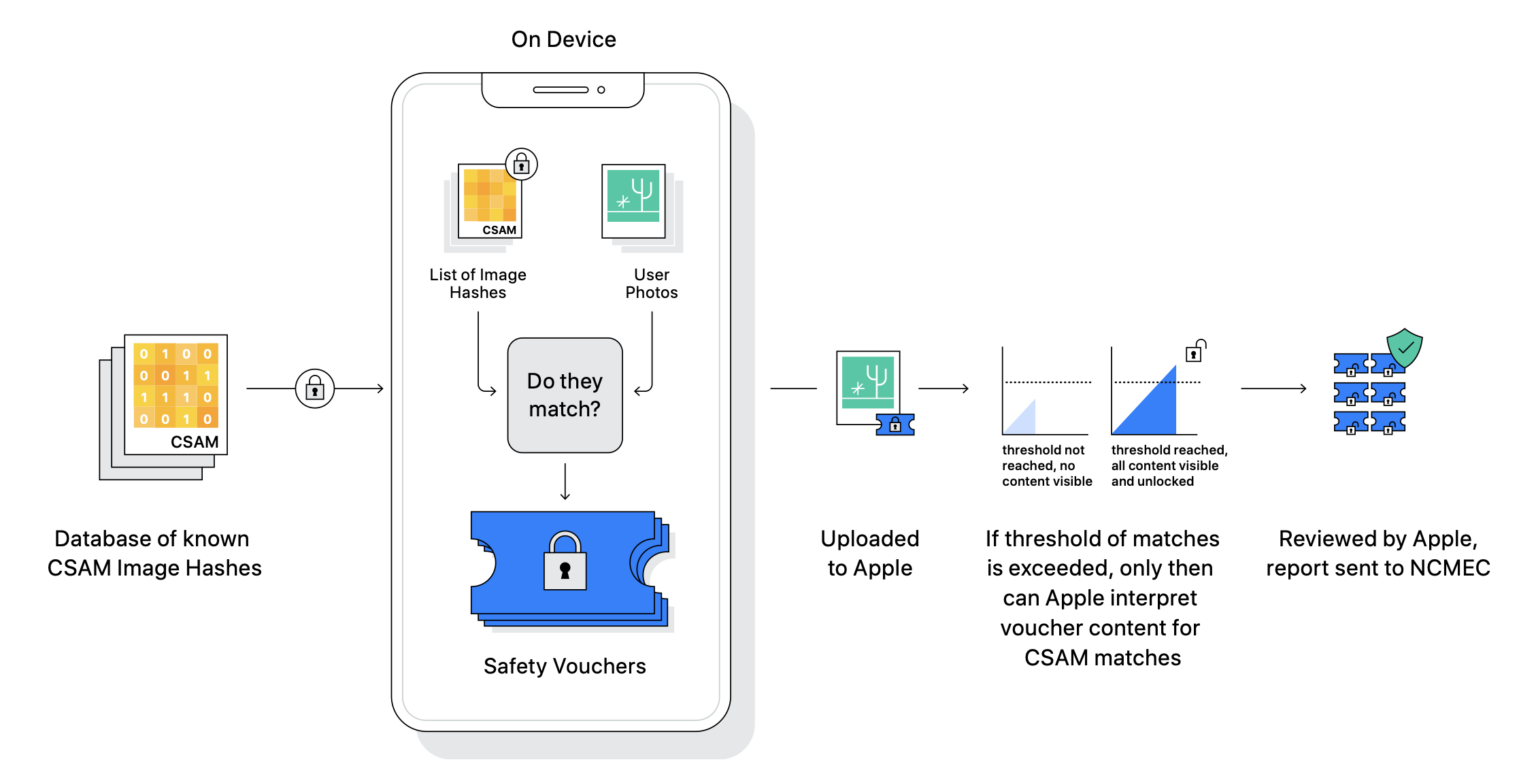

Y es que a diferencia de lo que hacen compañías como Facebook, Twitter, Microsoft, Google o Dropbox, que escanean las fotos que usted sube a sus servicios, el sistema planteado por Apple haría ese análisis en los dispositivos de los usuarios justo antes de que esas fotos sean cargadas a iCloud Photos.

Poco ha importado que el sistema de Apple sea mucho más privado que el de los demás -al no escanear cada foto sino al comparar los hashes (representaciones matemáticas) de cada una con los hashes de fotos reportadas a las autoridades como material pornográfico que involucra menores de edad- pues el foco se ha puesto en que dicha comparación se haga on device y no cuando las mismas se suben y almacenan en la nube.

Si quiere entender un poco más de cómo funciona el sistema lo invito a que escuche este capítulo de Hablemos de Apple en que discutimos sobre el tema cuando fue anunciado.